09/10/2024

A Física na Inteligência Artificial

Ganhadores do Nobel de Física 2024 são autores de descobertas e invenções que fundamentaram a aprendizagem de máquina baseada em redes neurais.

Na última terça-feira, dia 08 de outubro, a Real Academia Sueca de Ciências divulgou os nomes dos ganhadores do Prêmio Nobel de Física de 2024: eles são o norte-americano John J. Hopfield, da Universidade da Pensilvânia, e o inglês Geoffrey E. Hinton, da Universidade de Toronto.

Hopfield criou uma estrutura que é capaz de armazenar e reconstruir informações. Hinton inventou um método que, de forma independente, pode descobrir propriedades em dados e que se tornou importante para as grandes redes neurais em uso na atualidade.

Usando ferramentas da Física para encontrar padrões em informações, os dois cientistas ajudaram a fundamentar o poderoso aprendizado de máquina atual, que está notoriamente revolucionando a Ciência, a Engenharia e a vida diária.

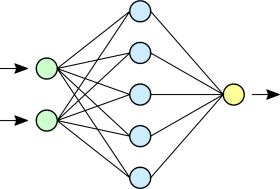

Esta tecnologia experimentou uma vertiginosa evolução nos últimos quinze a vinte anos, usando a estrutura chamada de rede neural artificial, e está por trás da capacidade dos computadores em traduzir idiomas, interpretar imagens e até mesmo dialogar conosco de modo razoável.

Ela também inclui a classificação e análise de grandes quantidades de dados, o que a torna importantíssima na condução de pesquisas. Quando falamos em inteligência artificial, frequentemente estamos nos referindo à tecnologia de aprendizagem de máquina com redes neurais.

Computadores ainda não podem pensar, mas podem imitar algumas funções cognitivas, tais como memória e aprendizado.

Aprendizado de máquina é diferente do software tradicional. Um programa de computador clássico é como uma receita de bolo, ou seja, um conjunto de instruções ordenadas (comandos), cuja execução em sequência produz o resultado.

No aprendizado de máquina, o computador aprende através de exemplos. Isto permite que ele resolva problemas que são muito vagos e complicados para que sejam tratados por instruções passo a passo. Um exemplo é a interpretação de uma imagem e identificação dos objetos que ela contém.

O que são redes neurais?

A origem da ideia de rede neural artificial reside no desejo da compreensão de como o cérebro funciona. Na década de 1940, pesquisadores começaram a investigar e construir o conhecimento sobre a matemática que fundamenta a rede de neurônios e sinapses cerebrais.

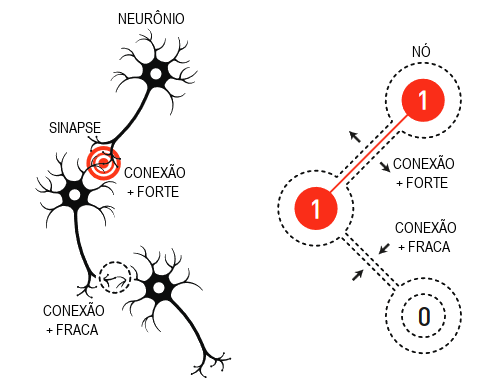

Outra peça do quebra-cabeça veio da Psicologia, graças à hipótese do neurocientista Donald Hebb sobre como o aprendizado acontece: as conexões entre os neurônios são reforçadas pelo fato de trabalharem juntos.

Posteriormente, vieram as tentativas de reprodução de tais propriedades, com a construção de simulações de redes neurais artificiais em computador. Nelas, o processamento das informações ocorre com a participação da estrutura como um todo, assim como ocorre no cérebro.

A hipótese de Donald Hebb é usada até hoje como uma das regras básicas para a atualização de redes artificiais por meio de um processo chamado training (treinamento).

Redes naturais e redes artificiais

A rede neural do cérebro humano (assim como a dos outros animais) é feita de células vivas, os neurônios, que dispõem de um avançado maquinário interno. Eles enviam sinais uns aos outros através das sinapses.

Nós, seres humanos, aprendemos coisas e, quando isto acontece, as conexões entre alguns deles tornam-se mais fortes, enquanto que outras enfraquecem.

O processo é semelhante nas redes neurais artificiais. As estruturas são constituídas por "nós", aos quais são atribuídos valores. Eles são os correlatos dos neurônios, e as sinapses são imitadas por conexões entre esses nós.

Quando a rede é "treinada", as conexões entre os nós que estiverem mais ativas ganham consistência, ocorrendo o contrário com as inativas. A analogia com a estrutura biológica fica evidente na ilustração a seguir:

No final da década de 1960, alguns resultados teóricos decepcionantes levaram muitos pesquisadores à suspeita de que essas tais redes neurais jamais seriam de qualquer utilidade real.

Nos anos 1980, entretanto, o interesse pelo tema foi revigorado, com o impacto de vários novos insights e descobertas, incluindo o trabalho dos físicos ganhadores do Nobel deste ano.

Memória associativa

Quando uma palavra nos foge à memória, forçamos a concentração em tentar relembrar, e acabamos encontrando primeiro outros termos, de significado ou sonoridade semelhante, até que cheguemos à palavra correta. Este processo é característico da memória associativa, descoberta pelo físico John Hopfield em 1982.

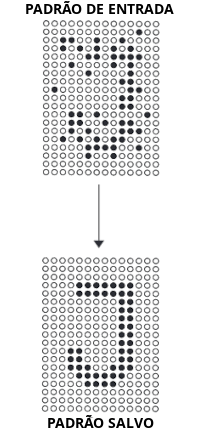

A rede Hopfield é capaz de armazenar padrões e tem um método para recriá-los. Quando ela recebe um padrão incompleto ou levemente distorcido, o método pode encontrar o padrão já armazenado que seja mais semelhante.

Hopfield já havia usado seus conhecimentos em Física para explorar problemas teóricos da Biologia Molecular. Certa vez, foi convidado para uma reunião sobre Neurociência, onde foi apresentado a pesquisas sobre a estrutura cerebral.

Ele ficou fascinado com o que aprendeu e, a partir de então, começou a pensar sobre a dinâmica de redes neurais simples, percebendo que, quando neurônios agem juntos, eles podem dar origem a novas e poderosas características, as quais não são evidentes se o foco estiver nos componentes individuais da rede.

Em 1980, Hopfield renunciou a seu cargo na Universidade de Princeton, onde seus interesses como pesquisador o distanciaram das áreas em que seus colegas físicos trabalhavam, e mudou-se para o outro lado do continente.

Ele aceitou a oferta de uma cátedra em Química e Biologia no Instituto de Tecnologia da Califórnia (Caltech - California Institute of Technology), em Pasadena, sul da Califórnia. Lá, teve acesso a recursos computacionais que facilitaram o desenvolvimento de suas ideias sobre redes neurais.

No entanto, ele não abandonou as bases de sua formação em Física, na qual encontrou a inspiração para o entendimento sobre como sistemas com muitos pequenos componentes operando juntos fazem com que surjam novos e interessantes fenômenos.

Em particular, Hopfield aproveitou-se de seu aprendizado sobre materiais magnéticos, os quais apresentam características especiais graças ao seu spin atômico - uma propriedade que torna cada átomo um pequeno ímã.

Os spins de átomos vizinhos afetam-se mutuamente, criando condições para a formação de domínios com spin na mesma direção. Hopfield criou um modelo de rede, com nós e conexões, usando a Física que descreve como os materiais se comportam devido à influência dos spins entre si.

Salvando imagens em uma paisagem

A estrutura de Hopfield é uma rede composta de nós unidos entre si por conexões de diferentes forças, e cada nó pode armazenar um valor individual. No primeiro trabalho realizado pelo físico, o valor pode ser 0 ou 1, como os pixels de uma tela em preto e branco.

Hopfield descreveu o estado geral da rede usando uma propriedade equivalente à energia do sistema de spins estudado na Física; a energia é calculada através de uma fórmula que usa todos os valores dos nós e a magnitude de todas as forças das conexões entre eles.

A rede é programada (treinada) por uma imagem formada pelos nós, onde cada um deles recebe o valor preto (0) ou branco (1). Então, as conexões são ajustadas pela fórmula da energia, de modo que a imagem salva seja de baixa energia.

Quando outro padrão é inserido na rede, há uma regra para percorrer os nós, um por um, e verificar se a rede terá menor energia se o valor do nó for alterado. Por exemplo, se for constatado que um pixel preto implicará em menos energia se for substituído por branco, a cor é mudada.

O procedimento continua, até que seja impossível encontrar quaisquer melhorias adicionais. Quando se chega a este ponto, a rede frequentemente reproduz a imagem original na qual foi treinada.

Você pode estar se perguntando: para que serve isso? Por que não salvar a imagem em si e compará-la com outra imagem sendo testada? O método pode não parecer muito útil se você salva apenas um padrão. Entretanto, ele é especial, pois várias imagens podem ser salvas ao mesmo tempo e a rede geralmente pode diferenciar entre elas.

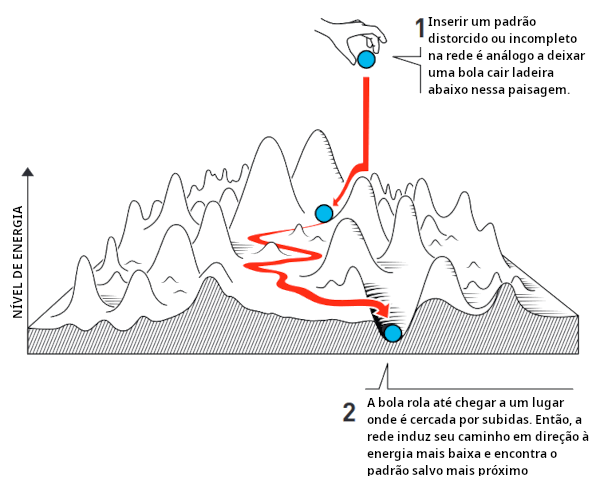

Hopfield comparou a busca por um estado salvo na rede a rolar uma bola por uma paisagem de picos e vales, com atrito que retarda seu movimento. Se a bola cai em um local específico, ela rola para baixo, em direção a ladeiras entre encostas.

Se a rede recebeu um padrão próximo a outro que esteja salvo, ela continuará avançando até chegar ao fundo de um vale da paisagem energética, assim encontrando, em sua memória, o padrão mais parecido.

Veja no infográfico:

Hopfield e outros cientistas continuaram a refinar detalhes no funcionamento da rede, passando a incluir nós capazes de armazenar qualquer valor, e não apenas zero ou um. Vemos imagens em uma tela de computador que exibem diferentes cores, e não apenas preto ou branco.

Métodos aprimorados possibilitaram salvar mais imagens e diferenciá-las, mesmo quando bem parecidas. É igualmente possível identificar ou reconstruir qualquer informação, desde que seja construída a partir de muitos pontos de dados.

Classificação usando a Física do século XIX

Lembrar-se de uma imagem é uma coisa, interpretá-la é outra e requer algo mais.

Até crianças muito pequenas podem apontar para um animal e dizerem, com segurança, se é um cachorro, um gato ou uma vaca. Podem até errar, de vez em quando, mas vão acertar na maioria das vezes.

As crianças aprendem naturalmente, sem a necessidade de diagramas ou explicações de conceitos, tais como os de espécie ou de mamífero. Como isso acontece?

Depois de vivenciar experiências envolvendo alguns exemplos de cada tipo de animal, as diferentes categorias se encaixam na cabeça da criança. Pessoas aprendem as coisas através da experimentação do ambiente ao seu redor.

Quando Hopfield publicou seu artigo sobre memória associativa, Geoffrey Hinton atuava na Carnegie Mellon University, em Pitsburgo, Pensilvânia. Ele se perguntava se máquinas poderiam aprender a processar padrões de maneira semelhante aos seres humanos. É possível que um computador encontre suas próprias categorias para classificar e interpretar informações?

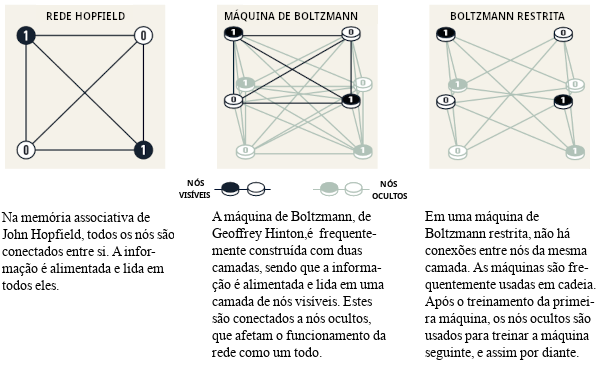

Em parceria com seu colega Terrence Sejnowski, Hinton trabalhou com a rede Hopfield e a expandiu para construir algo novo, usando ideias da Física Estatística, que descreve sistemas compostos por muitos elementos similares, como, por exemplo, as moléculas de um gás.

É muito difícil, ou mesmo impossível, fazer o rastreamento de todas essas moléculas em separado, mas é possível considerá-las coletivamente para determinar propriedades abrangentes do gás, tais como pressão e temperatura.

Existem muitas maneiras potenciais para que as moléculas de um gás se espalhem por seu volume em velocidades individuais e, ainda assim, apresentem as mesmas propriedades coletivas.

Os estados em que os componentes individuais podem coexistir são passíveis de serem analisados por métodos de Física Estatística, calculando a probabilidade de ocorrência desses estados. Alguns são mais prováveis que outros.

Isto depende da quantidade de energia disponível, que é descrita em uma equação do século XIX, de autoria do físico Ludwig Boltzmann, e esta foi a equação usada por Hinton em sua rede neural. O método foi publicado em 1985, com o nome de máquina de Boltzmann.

Identificando novos exemplos do mesmo tipo

A máquina de Boltzmann é comumente usada com dois diferentes tipos de nós. A informação é inserida em um desses grupos, que é o dos "nós visíveis". Os outros formam uma camada invisível, cujos valores e conexões contribuem para a energia da rede como um todo.

A máquina funciona com a aplicação de uma regra de atualização dos valores dos nós, um de cada vez. Eventualmente, o sistema assumirá um estado no qual o padrão dos nós pode mudar, mas as propriedades da rede como um todo permanecem as mesmas, assim como ocorre com os gases.

Cada padrão possível terá, então, uma probabilidade específica de ocorrer, que é determinada pela energia da rede, de acordo com a equação de Boltzmann. Quando a máquina para, ela criou um novo padrão, e isto torna a máquina de Boltzmann um exemplo inicial de modelo generativo.

A máquina de Boltzmann é capaz de aprender - não a partir de instruções, e sim seguindo exemplos dados. Ela é treinada mediante atualização dos valores nas conexões da rede, de modo que os padrões de exemplo, fornecidos aos nós visíveis, tenham a maior probabilidade de ocorrerem quando a máquina for executada.

Se o mesmo padrão for repetido várias vezes durante o treinamento, sua probabilidade é ainda maior. O treinamento também afeta a probabilidade de produção de novos padrões, semelhantes aos exemplos nos quais a máquina já foi treinada.

Uma máquina de Boltzmann treinada pode reconhecer traços familiares em informações às quais não teve acesso anteriormente, algo como conhecer o irmão de um amigo e identificar imediatamente que eles devem ser parentes.

De modo análogo, a máquina de Boltzmann é capaz de reconhecer um exemplo totalmente novo, se ele pertencer a uma categoria encontrada no material de treinamento, e distinguir as diferenças em relação a outros materiais.

Em seu formato original, esta máquina é bastante ineficiente, levando muito tempo para encontrar soluções. Ela se torna mais interessante quando é desenvolvida de outras maneiras, que Hinton continuou explorando. Versões posteriores foram reduzidas, com remoção de conexões entre algumas unidades, o que, na verdade, ocasiona um ganho de eficiência.

Embora, durante a década de 1990, muitos pesquisadores tenham perdido o interesse por redes neurais artificiais, Hinton foi um dos que deram continuidade a estudos na área. Ele contribuiu para o início de uma nova explosão de resultados excitantes.

em 2006, ele e seus colegas Simon Osindero, Yee Whye Teh e Ruslan Salakhutdinov desenvolveram um método para pré-treinar uma rede, usando uma série de máquinas de Boltzmann em camadas, uma sobre a outra. Este pré-treinamento deu às conexões um melhor ponto de partida, o que otimizou seu treinamento para reconhecer elementos em imagens.

A máquina de Boltzmann é frequentemente usada como parte de uma rede maior. Por exemplo, ela é muito útil para recomendar filmes ou seriados com base nas preferências dos espectadores.

Aprendizagem de máquina hoje e no futuro

Com os trabalhos que realizaram a partir da década de 1980, John Hopfield e Geoffrey Hinton ajudaram a estabelecer as bases da revolução do aprendizado de máquina, que teve início por volta de 2010.

A evolução estamos testemunhando nos dias de hoje tornou-se possível através do acesso a grandes volumes de dados, os quais são usados para o treinamento das redes, e também pelo vertiginoso aumento do poder de computação.

As atuais redes neurais artificiais são comumente enormes e contruídas com muitas camadas. Elas são chamadas de redes neurais profundas e a forma como são treinadas é chamada de aprendizado profundo.

O artigo sobre memória associativa, de 1982, fornece alguma perspectiva sobre esse desenvolvimento. Nele, Hopfield usou uma rede com 30 nós. Estando todos conectados uns aos outros, são 435 conexões. Os nós têm seus valores, as conexões diferentes forças e, no total, são menos de 500 parâmetros para acompanhar.

Ele também tentou uma rede com 100 nós, mas isto ficou muito complicado, tendo em vista o computador que usava na época. Os grandes modelos de linguagem atuais são construídos como redes que podem conter mais de um trilhão de parâmetros.

É interessante observar que a Física contribuiu com ferramentas para o desenvolvimento do aprendizado de máquina, e a própria Física teve um retorno positivo, beneficiando-se das redes neurais artificiais na realização de suas pesquisas.

A tecnologia já vem sendo usada há muito tempo, em campos de pesquisa que renderam, inclusive, Prêmios Nobel anteriores. Isso inclui o peneiramento e processamento de vastas quantidades de dados, necessários para a descoberta da partícula de Higgs; a redução de ruído em medições das ondas gravitacionais de buracos negros em colisão; a busca por exoplanetas, etc.

Nos últimos anos, o aprendizado de máquina também começou a ser usado no cálculo e previsão das propriedades de moléculas e materiais. Por exemplo, o cálculo da estrutura das moléculas de proteína, determinando sua função, e a descoberta de quais novas versões de um determinado material podem ter as melhores características para uso em células solares mais eficientes.

E muitos pesquisadores continuam desenvolvendo novas áreas de aplicação para o aprendizado de máquina. Quais serão mais viáveis ainda não se sabe, e também há uma ampla discussão acerca de questões éticas relacionadas ao desenvolvimento e uso desta tecnologia.

- publicada em 12/10/2024.

- publicada em 12/10/2024.★ A maior parte do conteúdo principal resulta de traduções livres e interpretação das seguintes fontes:

- The Nobel Foundation (nobelprize.org);

- Royal Swedish Academy of Sciences - The Nobel Prize in Physics 2024: Popular Science Background .